Cristian_Bednar

New member

- Registrado

- 27 Sep 2024

- Mensajes

- 42

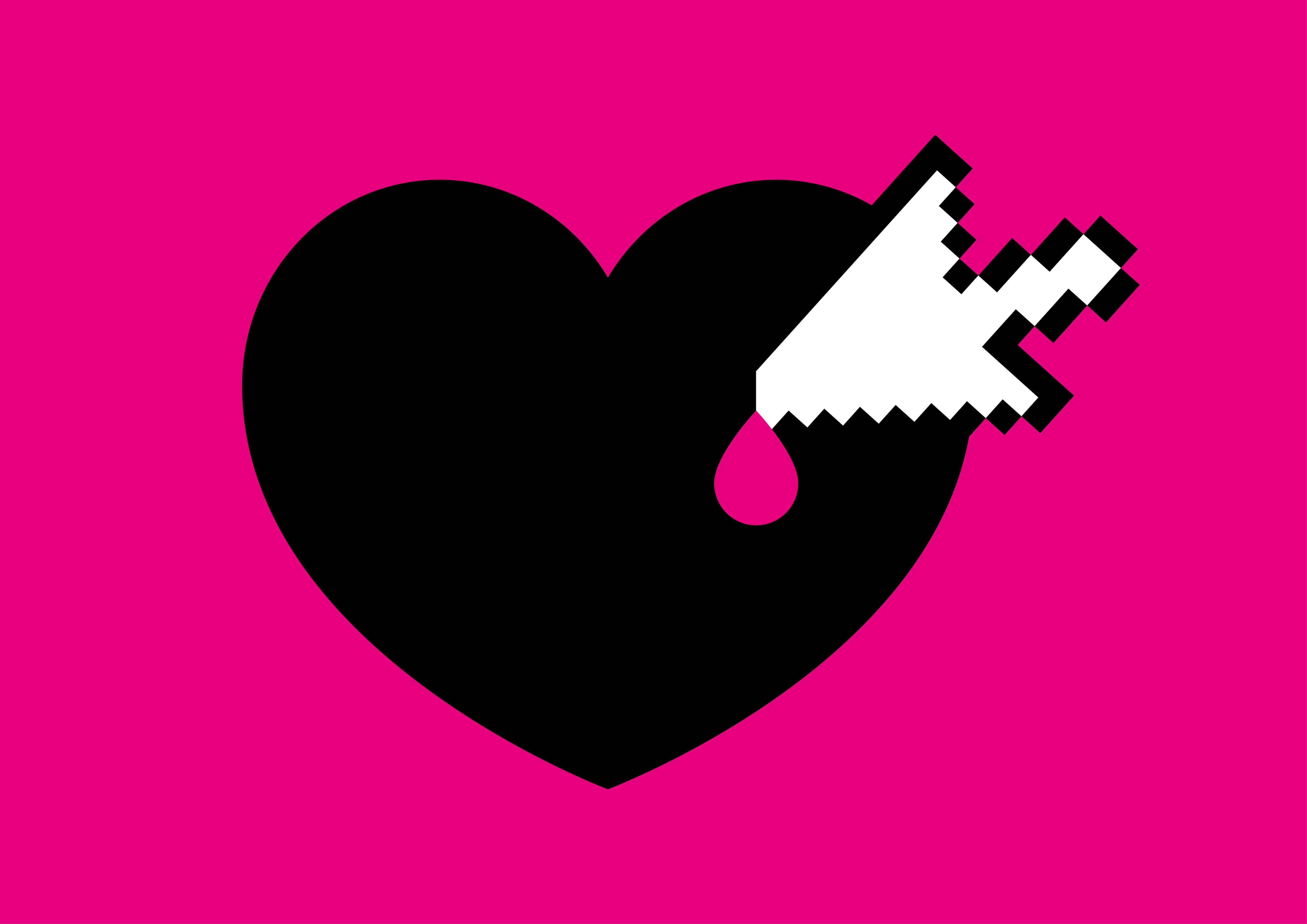

Sewell Setzer, un estadounidense de 14 años, se pegó un tiro en la cabeza en su casa en febrero. El adolescente, diagnosticado de síndrome de asperger leve, estaba enamorado de Daenerys Targaryen, con quien chateaba cada noche durante horas. No hablaba con alguien, sino con algo: un perfil de la plataforma Character.AI, que ofrece conversaciones con gran variedad de personajes reales o ficticios, como este de Juego de Tronos, creados con inteligencia artificial (IA) generativa, la que está detrás de aplicaciones como ChatGPT. La madre del joven, Megan Garcia, acaba de presentar una demanda contra Character.AI, empresa a la que culpa de la muerte de su hijo por brindar al público tecnología “peligrosa y no probada” que puede “engañar a los clientes para que entreguen sus pensamientos y sentimientos más privados” y que ofrece “experiencias antropomórficas, hipersexualizadas y aterradoramente realistas”. Setzer se obsesionó con su novia virtual e interpretó algunos de sus comentarios como un empujón para apretar el gatillo.

Seguir leyendo

Cargando…

elpais.com