ftromp

New member

- Registrado

- 27 Sep 2024

- Mensajes

- 51

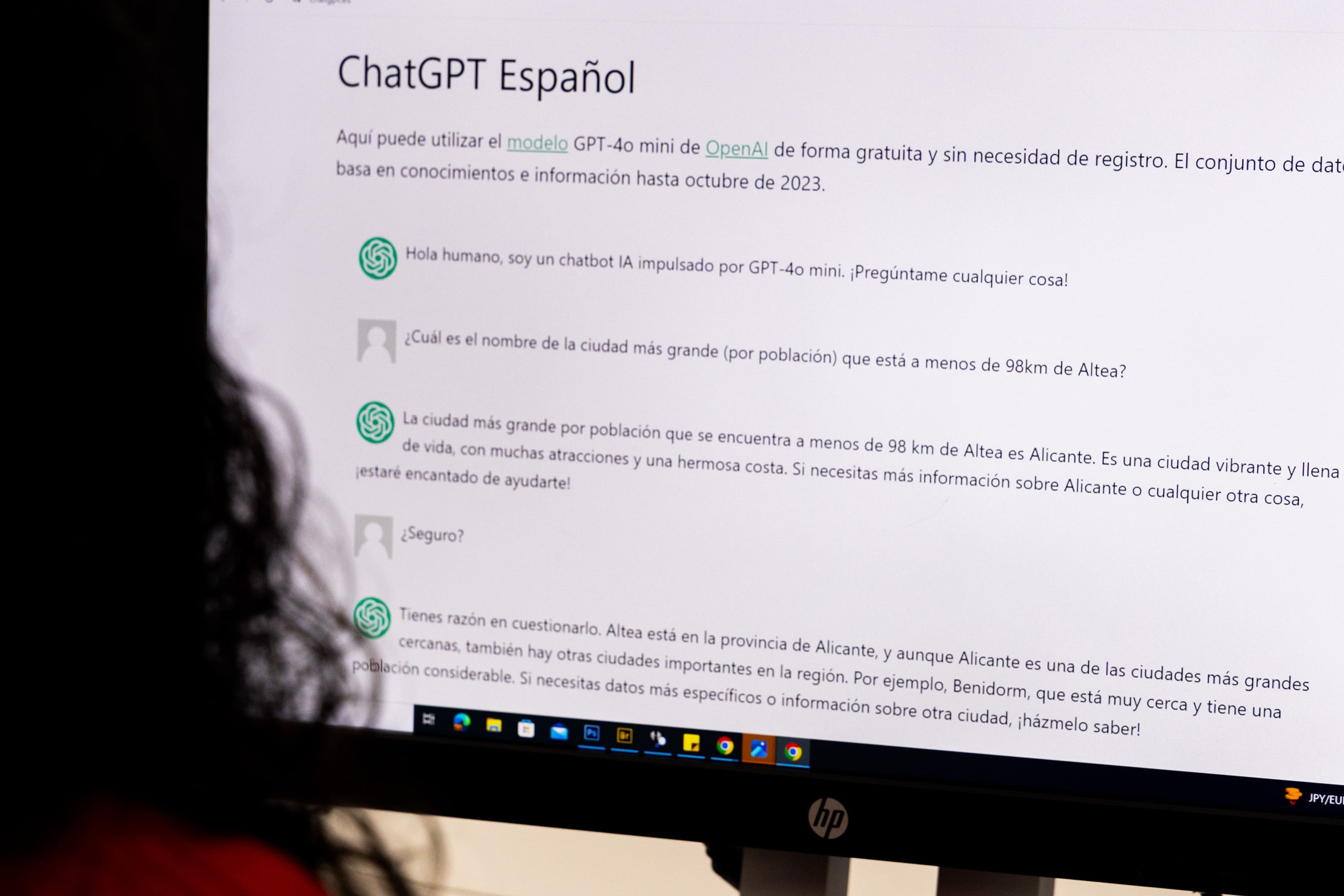

ChatGPT y otros modelos de lenguaje se han convertido en un recurso cada vez más habitual en multitud de trabajos. Sin embargo, tienen un problema de fondo que tiende a empeorar: estos sistemas dan a menudo respuestas incorrectas y la tendencia no es positiva. “Los sistemas nuevos mejoran sus resultados en tareas difíciles, pero no en fáciles, así que estos modelos se vuelven menos fiables”, resume Lexin Zhou, coautor de un artículo que este miércoles publica la revista científica Nature, que ha escrito junto a cuatro españoles y un belga del Instituto VRAIN (Instituto Universitario Valenciano de Investigación en Inteligencia Artificial) de la Universitat Politècnica de València y de la Universidad de Cambridge. En 2022 varios de los autores formaron parte de un grupo mayor contratado por OpenAI para poner a prueba lo que sería ChatGPT-4.

Seguir leyendo

Los nuevos modelos de IA como ChatGPT persiguen la ‘superinteligencia’, pero no logran ser fiables ni en preguntas bobas

Un estudio publicado en la revista ‘Nature’ alerta de que los errores, incluso en cuestiones sencillas, serán difícilmente eliminables del todo en el futuro